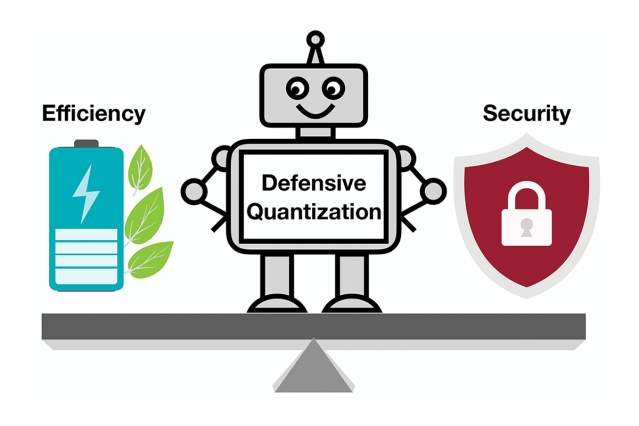

Các nhà nghiên cứu tiết lộ một công cụ để làm cho các mô hình học compressed deep learning ( mô tả một phương pháp

để nén DNN mà không mất độ chính xác thông qua việc kết hợp lược bớt và chia sẻ trọng lượng.)

- mô hình học ít bị tấn công và bảo mật hơn.

Kim Martineau | MIT Quest for Intelligence

April 23, 2019

Điện thoại thông minh, camera an ninh và loa chỉ một vài trong số các thiết bị sẽ sớm chạy thêm phần mềm trí tuệ

nhân tạo để tăng các tác vụ xử lý hình ảnh và giọng nói. Một kỹ thuật nén ("A compression technique") được gọi

là lượng tử hóa đang trơn tru hơn bằng cách làm cho các mô hình học tập sâu nhỏ hơn để giảm chi phí tính toán và năng lượng.

Nhưng các mô hình nhỏ hơn, hóa ra, giúp những kẻ tấn công dễ dàng đẩy hệ thống AI vào hoạt động phạm pháp - một mối quan tâm

khi mà việc ra quyết định phức tạp hơn được đưa ra cho máy móc.

Trong một nghiên cứu mới, các nhà nghiên cứu của MIT và IBM chỉ ra rằng các mô hình AI (compressed deep learning) dễ

bị tấn công như thế nào và họ đưa ra cách khắc phục : thêm một ràng buộc toán học trong quá trình lượng tử hóa để giảm

tỷ lệ AI sẽ trở thành con mồi cho một hình ảnh được sửa đổi một chút và phân loại sai những gì họ nhìn thấy.

Khi mô hình " compressed deep learning" bị giảm từ 32 bit tiêu chuẩn xuống độ dài bit thấp hơn, nó có nhiều khả năng

phân loại sai các hình ảnh bị thay đổi do hiệu ứng khuếch đại lỗi : Hình ảnh bị điều chỉnh trở lên méo mó hơn với mỗi lớp

xử lý thêm. Cuối cùng mô hình có nhiều khả năng nhầm lẫn . Ví dụ : một con chim với một con mèo hay một con ếch cho một con nai.

Các mô hình được lượng tử hóa từ 8 bit trở xuống dễ bị tấn công bất lợi hơn, các nhà nghiên cứu cho thấy, với độ chính xác giảm từ

mức thấp 30-40% xuống dưới 10% khi độ rộng bit giảm. Nhưng việc kiểm soát các ràng buộc của Lipschitz trong quá trình

lượng tử hóa sẽ khôi phục một số khả năng phục hồi. Khi các nhà nghiên cứu thêm vào các ràng buộc, họ đã thấy hiệu

xuất tăng lên đáng kể trong 1 cuộc tấn công, với các mô hình nhỏ hơn trong một số trường hợp vượt trội hơn mô hình 32 bit.

Các mô hình " compressed deep learning" cần phải nhanh chóng và an toàn khi loài người di chuyển chúng vào một thế

giới của các thiết bị kết nối Internet, theo lời đồng tác giả nghiên cứu Chuang Gan, một nhà nghiên cứu tại Phòng thí nghiệm AI-MIT Watson của MIT.

Bình luận